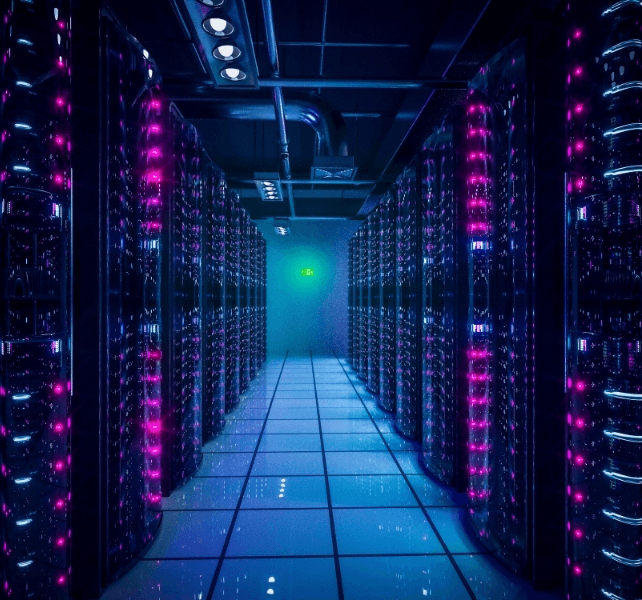

La industria de la inteligencia artificial se esfuerza por reducir su enorme consumo de energía a través de mejores sistemas de refrigeración, chips informáticos más eficientes y una programación más inteligente, todo ello mientras el uso de IA explota en todo el mundo. La IA depende completamente de los centros de datos, que podrían consumir el 3% de la electricidad mundial para 2030, según la Agencia Internacional de la Energía. Eso es el doble de lo que consumen actualmente. Los expertos de McKinsey, una consultora estadounidense, describen una carrera para construir suficientes centros de datos para satisfacer el rápido crecimiento de la IA, al tiempo que advierten que el mundo se dirige hacia una escasez de electricidad.

“Hay varias maneras de resolver el problema”, explicó Mosharaf Chowdhury, profesor de informática de la Universidad de Michigan.

Las empresas pueden generar más suministro de energía (lo que lleva tiempo y los gigantes de la IA ya están recorriendo el mundo para lograrlo) o descubrir cómo consumir menos energía para la misma potencia de procesamiento.

Chowdhury cree que el desafío se puede afrontar con soluciones “inteligentes” en todos los niveles, desde el hardware físico hasta el propio software de IA. Por ejemplo, su laboratorio ha desarrollado algoritmos que calculan exactamente cuánta electricidad necesita cada chip de IA, reduciendo el uso de energía en un 20-30%.

Soluciones ‘inteligentes’

Hace veinte años, operar un centro de datos (incluyendo sistemas de refrigeración y otra infraestructura) requería tanta energía como hacer funcionar los propios servidores. Hoy en día, las operaciones utilizan sólo el 10% de lo que consumen los servidores, afirma Gareth Williams de la consultora Arup.

Esto se debe en gran medida a este enfoque en la eficiencia energética. Muchos centros de datos ahora utilizan sensores impulsados por IA para controlar la temperatura en zonas específicas en lugar de enfriar edificios enteros de manera uniforme.

Esto les permite optimizar el uso del agua y la electricidad en tiempo real, según Pankaj Sachdeva de McKinsey. Para muchos, el cambio radical será la refrigeración líquida, que reemplaza el rugido de los aparatos de aire acondicionado que consumen mucha energía por un refrigerante que circula directamente a través de los servidores.

“Todos los grandes jugadores lo están mirando”, dijo Williams.

Esto es importante porque los chips de IA modernos de empresas como Nvidia consumen 100 veces más energía que los servidores de hace dos décadas. AWS, el negocio de computación en la nube líder a nivel mundial de Amazon, dijo la semana pasada que había desarrollado su propio método líquido para enfriar las GPU Nvidia en sus servidores, evitando tener que reconstruir los centros de datos existentes.

“Simplemente no habría suficiente capacidad de refrigeración líquida para soportar nuestra escala”, dijo Dave Brown, vicepresidente de servicios de computación y aprendizaje automático de AWS, en un video de YouTube.

Estados Unidos contra China

Para Sachdeva de McKinsey, un factor tranquilizador es que cada nueva generación de chips de computadora es más eficiente energéticamente que la anterior. Una investigación de Yi Ding de la Universidad de Purdue ha demostrado que los chips de IA pueden durar más sin perder rendimiento.

“Pero es difícil convencer a las empresas de semiconductores de que ganen menos dinero” alentando a los clientes a seguir utilizando el mismo equipo durante más tiempo, añadió Ding.

Sin embargo, aunque es probable que una mayor eficiencia en los chips y en el consumo de energía hagan que la IA sea más barata, eso no reducirá el consumo total de energía.

“El consumo de energía seguirá aumentando”, predijo Ding, a pesar de todos los esfuerzos por limitarlo. “Pero quizá no tan rápido”.

En Estados Unidos, ahora se considera que la energía es clave para mantener la ventaja competitiva del país sobre China en IA. En enero, la startup china DeepSeek presentó un modelo de IA que funcionó tan bien como los mejores sistemas estadounidenses a pesar de utilizar chips menos potentes y, por extensión, menos energía.

Los ingenieros de DeepSeek lograron esto programando sus GPU con mayor precisión y omitiendo un paso de entrenamiento que consume mucha energía y que anteriormente se consideraba esencial. También se teme que China esté muy por delante de Estados Unidos en cuanto a fuentes de energía disponibles, incluidas las renovables y la nuclear.

Fuente: Science Alert.