Tus conversaciones con asistentes de IA como ChatGPT y Google Gemini podrían no ser tan privadas como crees. Microsoft ha revelado una grave vulnerabilidad en los grandes modelos de lenguaje (LLM) que impulsan estos servicios de IA, lo que podría exponer el tema de tus conversaciones. Los investigadores denominaron a esta vulnerabilidad “Whisper Leak” y descubrieron que afecta a casi todos los modelos que probaron.

Cuando conversas con asistentes de IA integrados en los principales buscadores o aplicaciones, la información está protegida por TLS (Seguridad de la Capa de Transporte), el mismo cifrado que se usa para la banca en línea. Estas conexiones seguras impiden que posibles intrusos lean lo que escribes. Sin embargo, Microsoft descubrió que los metadatos (cómo viajan tus mensajes por internet) siguen siendo visibles. WhisperLeak no vulnera el cifrado, pero se aprovecha de lo que este no puede ocultar.

Prueba de LLM

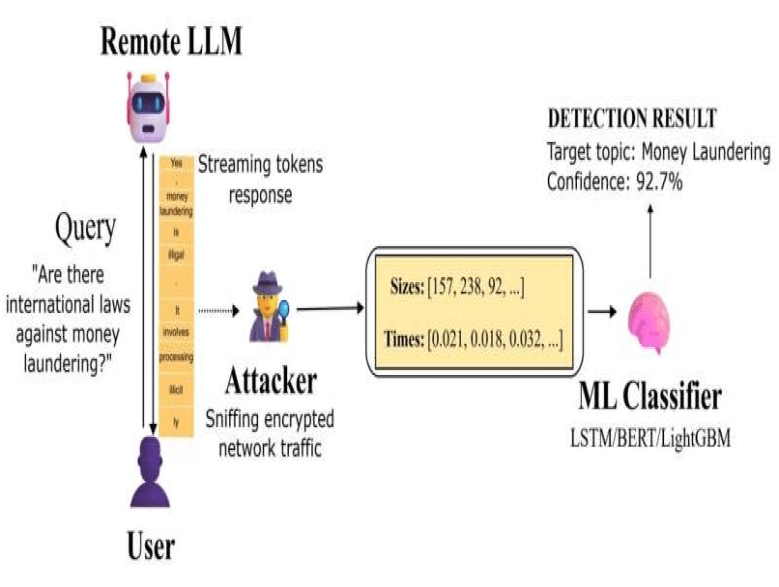

En una investigación publicada en el servidor de preimpresión arXiv, investigadores de Microsoft explican cómo analizaron 28 LLM para detectar esta vulnerabilidad. Primero, crearon dos conjuntos de preguntas. Uno consistía en una colección de diversas maneras de preguntar sobre un único tema delicado, como el blanqueo de capitales, y el otro conjunto contenía miles de consultas aleatorias y cotidianas. Posteriormente, registraron de forma secreta el ritmo de datos de cada red. Esto incluye el tamaño de los paquetes (fragmentos de datos que se envían) y la temporización (el retardo entre el envío de un paquete y su llegada).

A continuación, entrenaron un programa de IA para distinguir los temas sensibles de las consultas cotidianas basándose únicamente en el ritmo de los datos. Si la IA lograba identificar los temas sensibles sin leer el texto cifrado, se confirmaría un problema de privacidad.

En la mayoría de los modelos, la IA adivinó correctamente el tema de conversación con una precisión superior al 98%. El ataque también logró identificar conversaciones delicadas en el 100% de los casos, incluso cuando estas se presentaban solo en 1 de cada 10.000 conversaciones. Los investigadores probaron tres métodos distintos de defensa contra los ataques, pero ninguno logró detenerlos por completo.

Deteniendo la fuga

Según el equipo, el problema no reside en el cifrado en sí, sino en cómo se transmiten las respuestas. “No se trata de una vulnerabilidad criptográfica en TLS, sino de la explotación de los metadatos que TLS revela inherentemente sobre la estructura y la sincronización del tráfico cifrado”.

Dada la gravedad de la filtración y la facilidad con que se puede ejecutar el ataque, los investigadores afirman claramente en su artículo que la industria debe proteger los sistemas futuros. “Nuestros hallazgos subrayan la necesidad de que los proveedores de gestión del aprendizaje automático aborden la fuga de metadatos a medida que los sistemas de IA manejan información cada vez más sensible”.

Fuente: Tech Xplore.