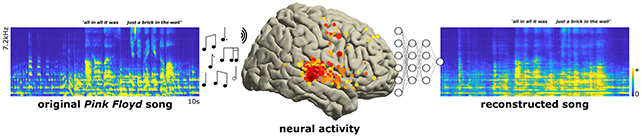

Estamos viendo importantes avances en tecnología que pueden decodificar señales cerebrales, interpretar la actividad neuronal para revelar lo que alguien piensa, lo que quiere decir o, en el caso de un nuevo estudio, qué canción está escuchando.

Investigadores estadounidenses han podido reconstruir una “versión reconocible” de una canción de Pink Floyd basada en los pulsos de actividad que se mueven a través de una parte específica del lóbulo temporal del cerebro en voluntarios mientras escuchaban el éxito Another Brick in the Wall Part 1.

Si bien la melodía en cuestión pasó por un procesamiento inicial en forma de espectrograma para ser más compatible con las técnicas de procesamiento de audio del cerebro, el proceso inverso es impresionante en términos de su fidelidad.

“Reconstruimos la canción clásica de Pink Floyd, Another Brick in the Wall, a partir de grabaciones corticales humanas directas, proporcionando información sobre las bases neuronales de la percepción de la música y sobre futuras aplicaciones de decodificación cerebral”, dice el neurocientífico Ludovic Bellier de la Universidad de California, Berkeley.

Bellier y sus colegas querían ver cómo los patrones cerebrales podrían asignarse a elementos musicales como el tono y la armonía y terminaron descubriendo que una parte del complejo auditivo del cerebro llamado giro temporal superior (STG) está vinculado al ritmo. Parece que esta área en particular es importante en términos de percepción y comprensión de la música.

Para recopilar los datos de actividad cerebral necesarios, el equipo reclutó a 29 personas a las que ya se les habían implantado electrodos cerebrales para ayudar a controlar su epilepsia. En todos los participantes, se monitorearon un total de 2668 electrodos en busca de patrones neuronales mientras escuchaban a Pink Floyd.

Luego, todos estos datos se analizaron a través del aprendizaje automático, a través de lo que se conoce como un modelo de decodificación basado en regresión. En términos simples, los algoritmos informáticos buscaban correlaciones entre la música que se reproducía y lo que sucedía en el cerebro.

A través de ese proceso de aprendizaje, los investigadores pudieron revertir el sistema e identificar la canción a través de cómo respondía el cerebro. La pista reconstruida está un poco embarrada y distorsionada, pero no es difícil saber cuál es la canción.

Esto contribuye a los esfuerzos en curso para decodificar mejor los patrones cerebrales y mejorar las interfaces cerebro-máquina. Imagina poder restaurar la percepción de la música para aquellos con daño cerebral, por ejemplo, o aquellos que han perdido el poder del habla y poder pensar las palabras que quieren decir, y también el tono, el tono y el flujo lírico de esas palabras.

“Por ejemplo, los hallazgos de la percepción musical podrían contribuir al desarrollo de un decodificador auditivo general que incluya los elementos prosódicos del habla basados en relativamente pocos electrodos bien ubicados”, escriben los investigadores en su artículo publicado.

La investigación ha sido publicada en PLOS Biology.

Fuente: Science Alert.